llama dify,在你的电脑搭建一套ai工作流 | learnku 产品论坛-380玩彩网官网入口

点赞 关注 收藏 = 学会了

最近字节在推coze,你可以在这个平台制作知识库、制作工作流,生成一个具有特定领域知识的智能体。

那么,有没有可能在本地也部署一套这个东西呢?这样敏感数据就不会泄露了,断网的时候也能使用ai。

刚好最近 llama 3.1 发布了,本文就以 llama 3.1 作为基础模型,配合 dify 在本地搭建一套“coze”。

跟着本文一步步操作,保证能行!

dify 380玩彩网官网入口官网() 的自我介绍:dify 是开源的 llm 应用开发平台。提供从 agent 构建到 ai workflow 编排、rag 检索、模型管理等能力,轻松构建和运营生成式 ai 原生应用。比 langchain 更易用。

在本地搭建这个平台很简单,其实 dify文档() 里都写得明明白白了,而且还有中文文档。

具体来说需要做以下几步:

- 安装

ollama - 下载大模型

- 安装

docker - 克隆

dify源代码至本地 - 启动

dify - 配置模型

接下来一步步操作。

安装 ollama

简单来说 ollama 是运行大语言模型的环境,这是 ollama 的380玩彩网官网入口官网地址 download 按钮下载 ollama 客户端,然后傻瓜式安装即可(一直点“下一步”)。

安装完成后就能看到一个羊驼的图标,点击运行它即可。

下载大模型

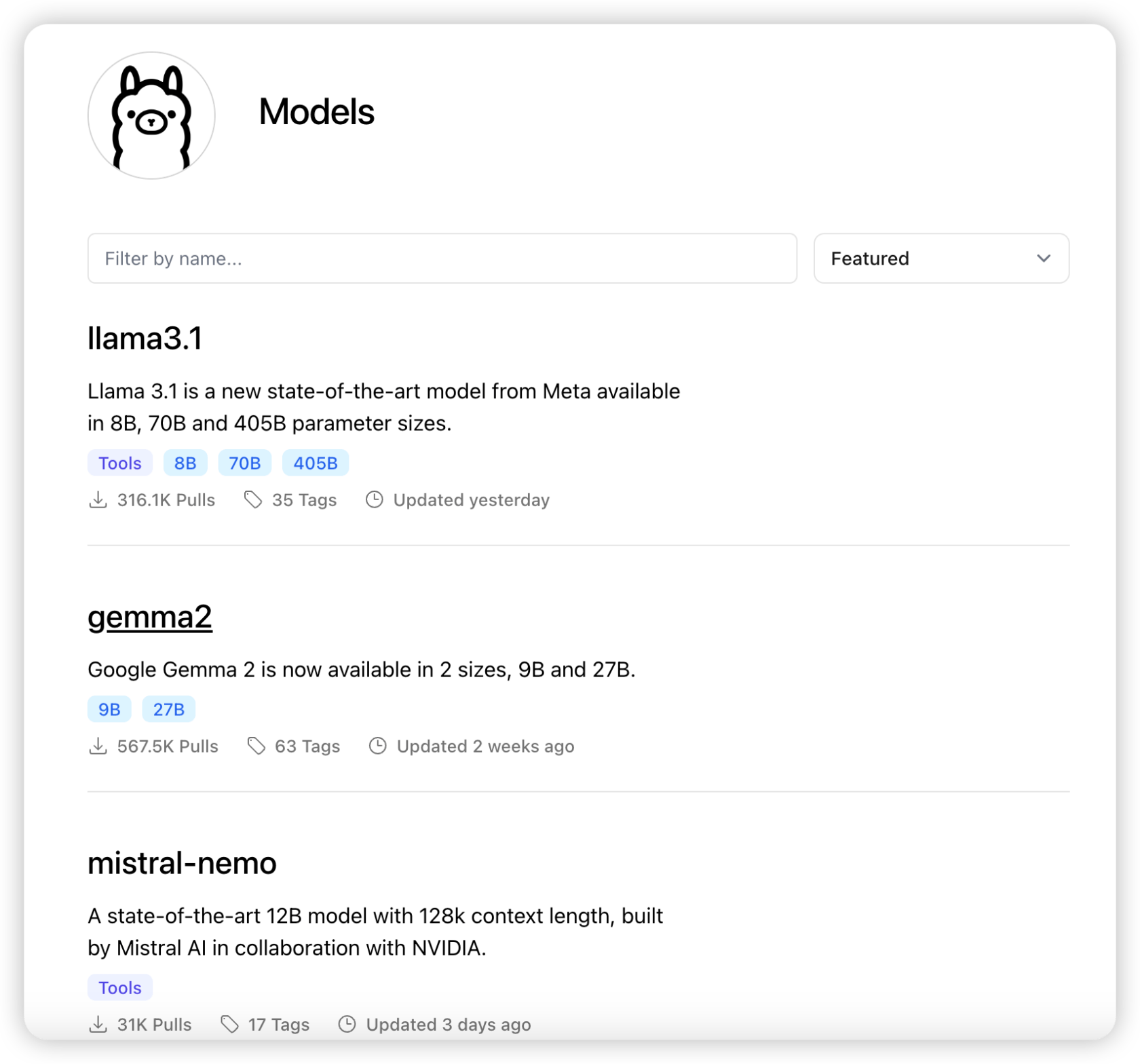

安装完 ollama 后,我们到 ollama 380玩彩网官网入口官网的模型页面(

这里面有很多开源模型,比如阿里的千问2,搜索 qwen2 就能找到它。

本文使用 llama 3.1 ,这是前两天才发布的模型,纸面参数贼强。

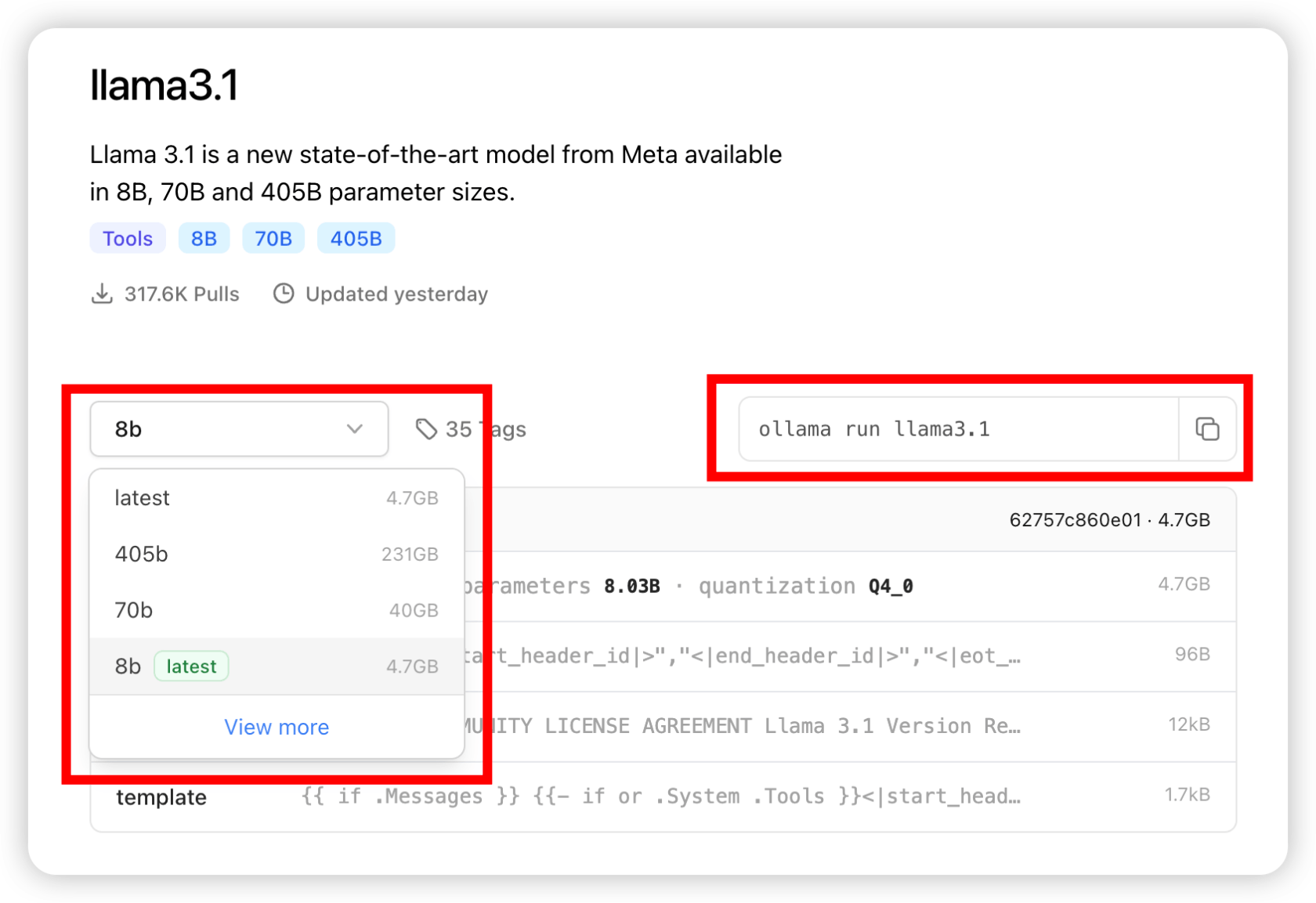

打开 llama 3.1 模型的地址( 8b 版。

选好版本后,复制上图右侧红框的命令,到你电脑的终端中运行。

如果你还没下载过这个模型它就会自动下载,如果已经下载过它就会运行这个模型。

运行后,你就可以在终端和大模型对话了。

当然,我们不会这么原始的在终端和大模型对话,我们可是要搞工作流的!

安装 docker

前面的基础步骤都搞掂了,接下来就要开始为运行 dify 做准备了。

先安装一下 docker ,打开 docker 380玩彩网官网入口官网(

克隆 dify 源代码至本地

要使用 dify ,首先要将它拉到你电脑里。

git clone https://github.com/langgenius/dify.git在你电脑里找个位置(目录),用 git 将 dify 克隆下来,用上面这条命令克隆就可以了。

启动 dify

进入 dify 源代码的 docker 目录,执行一键启动命令:

cd dify/docker

cp .env.example .env

docker compose up -d启动完成后,你的 docker 里就会看到这个

此时你在浏览器输入 http://localhost 就能看到这个界面。

首次打开 dify 需要你设置一下管理员的账号。

然后用管理员账号登录,可以看到下面这个页面。

点击“创建空白应用”就可以创建聊天助手、文本生成应用、agent、工作流。

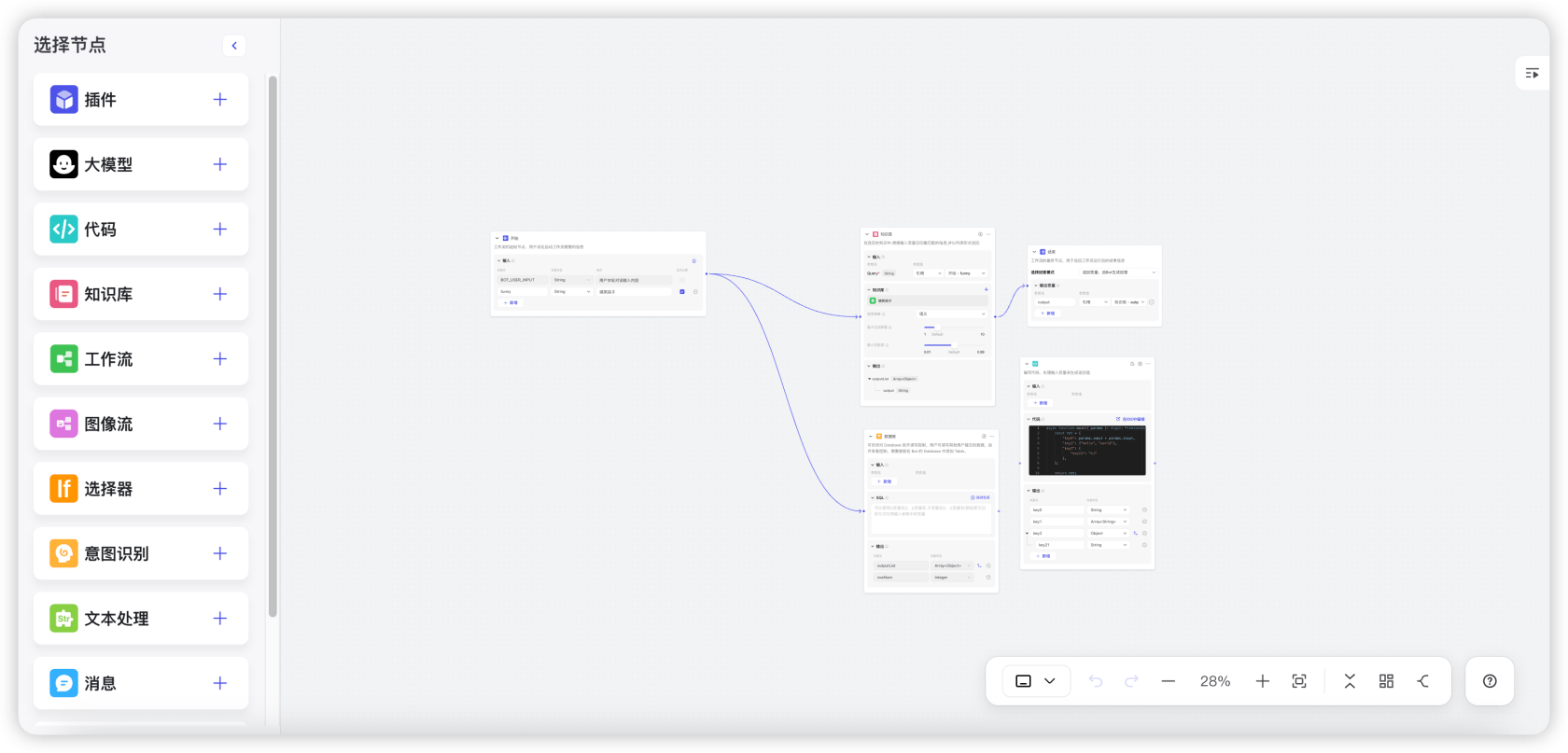

我们点击”工作流”就能看到类似coze的工作流编辑界面了。

配置模型

在配置工作流之前,我们需要给 dify 配置大语言模型。

点击页面右上角的管理员头像,然后选择“设置”。

选择“模型供应商”,然后点击“ollama”的卡片添加模型。

在添加 ollama 模型时,弹窗的左下角有一个“如何继承 ollama”的按钮,点击它会跳转到 dify 官方文档教你怎么配置,但这里可能会有个小坑。

前面我们已经使用 ollama 把 llama 3.1 运行起来了,在浏览器打开 ` 看到这个界面证明模型运行成功。

此时在“添加 ollama”将资料填写好,“基础 url”里输入 http://localhost:11434 即可。

如果你是 mac 电脑,填入以上资料有可能会报这个错:

an error occurred during credentials validation: httpconnectionpool(host='localhost', port=11434): max retries exceeded with url: /api/chat (caused by newconnectionerror(': failed to establish a new connection: [errno 111] connection refused' ))此时你需要在“基础 url”里填入 http://host.docker.internal:11434。

遇到问题可以看 dify 官方文档的 faq。

添加完成后你就可以在模型列表里看到它了。

除了接入 ollama 外,dify 还支持接入 openai 等闭源模型,但需要你去 openai 那边买个服务。

以上就是本文的全部内容啦,如果本文对你有帮助的话也请你分享给你的朋友~

点赞 关注 收藏 = 学会了

本作品采用《cc 协议》,转载必须注明作者和本文链接

感谢分享

我自己的知识库就是用dify本地搭建的,再也不用担心忘记自己的笔记写哪里了

感谢用心分享~